13. 两层神经网络

在之前的课程和实验室中,你已经学会了如何建立一层神经网络。现在,你将学习如何使用TensorFlow构建多层神经网络。添加一个隐藏层到网络让它建模更复杂的功能。而且,在隐藏层上使用非线性激活函数可以模拟非线性函数。

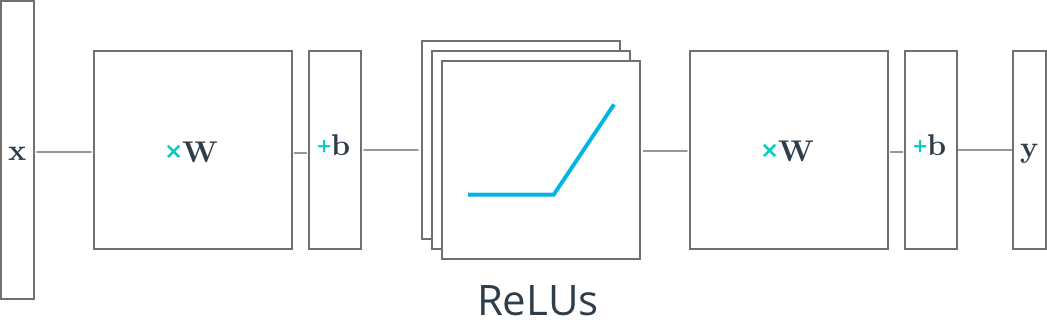

我们将学习在TensorFlow中实现的第一件事是ReLU隐藏层。 ReLU是一个非线性函数,又称修正线性单元。ReLU函数对于所有负的输入,返回为 0, ReLU 函数对所有负的输入,返回 0;所有 x >0 的输入,返回 x。

和之前一样,下面的节点将建立在深度神经网络课程基础上。如果你需要重新理清思绪,你可以回顾一遍。

- ReLU:参考本章

训练神经网络-其他激活函数 - Feedforward:参考本章

神经网络简介-前向反馈 - Dropout:参考本章

训练神经网络-Dropout